گوگل پربازدیدترین موتور جستجوی جهان است.طبق آمار SimilarWeb در سال 2023، گوگل با میانگین 92.5 میلیارد بازدید در ماه، رتبه اول را در بین پربازدیدترین وب سایت های جهان از لحاظ کاربر در رتبه اول جهان و بالاتر از یوتیوب قرار دارد. روزانه میلیاردها نفر برای یافتن پاسخ سؤالات خود به این سایت مراجعه میکنند. اما آیا تا به حال به این موضوع فکر کردهاید که گوگل چگونه میلیاردها صفحه وب را در عرض چند ثانیه بررسی میکند تا مرتبطترین نتایج جستجو را به شما نمایش دهد؟ و یا این که جستجوی گوگل چگونه کار میکند؟ همه اینها به لطف الگوریتمهای پیچیده و در حال تکاملی است که در دل گوگل وجود دارند.

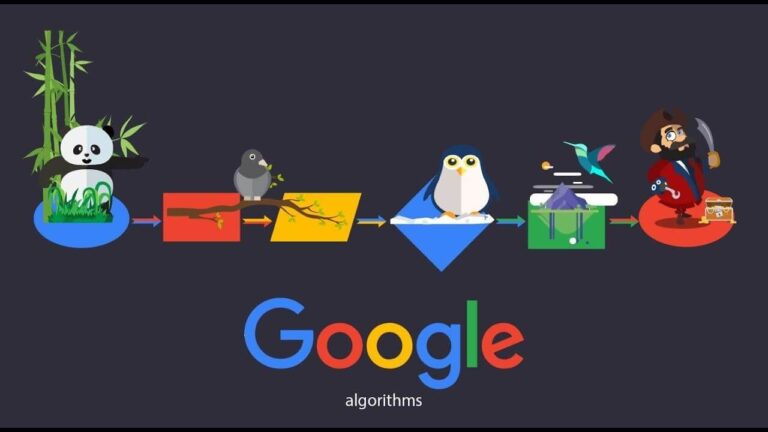

ما در این مقاله از دی ام سرویس قصد داریم شما را با کامل ترین لیست الگوریتم های گوگل در سئو، تاریخچه و کاربرد آنها آشنا کنیم و مهمترین این الگوریتمها را به شما معرفی کنیم. لطفاً در ادامه با ما همراه باشید.

الگوریتم چیست؟

بیشتر ما با مفهومی به نام الگوریتم در ریاضیات آشنایی داریم. الگوریتمها قواعدی مرحله به مرحله هستند که بیشترین کاربرد را در برنامهنویسی و کامپیوتر دارند. اساس نرم افزارها همین الگوریتمها هستند که با استفاده از آنها رفتارهای کاربر بررسی میشود و پاسخی به این رفتارها توسط نرم افزار داده میشود. الگوریتمها از شروط، حلقهها و ساختارهای دستوری مختلفی برای دریافت اطلاعات از ورودی، پردازش آنها و ارائه خروجی استفاده میکنند.

الگوریتم گوگل چیست؟

الگوریتمهای گوگل سیستمهای پیچیدهای از قوانین و محاسبات هستند که تعیین میکنند سایتها چگونه در نتایج جستجو رتبهبندی شوند. این الگوریتمها برای بهبود کیفیت نتایج جستجو و مبارزه با لینکهای اسپم و سایر روشهای دور زدن گوگل به طور مداوم به روز میشوند. به عبارت دیگر وقتی شما یک کلمه کلیدی را در فیلد جستجوی گوگل وارد میکنید و اینتر را میزنید، گوگل با کمک این الگوریتمها در بین میلیونها دادهای که از سایتها جمعآوری کرده است، در عرض چند ثانیه سایتها را رتبهبندی میکند و آنها را به ترتیب امتیازاتشان به شما نمایش میدهد.

مهمترین معیارهایی که الگوریتمهای گوگل از آنها برای تشخیص کیفیت و رتبه بالای محتوا استفاده میکنند شامل ارزش محتوای صفحات، اعتبار دامنه، لینکها و ارتباطات سایت، میزان ارتباط صفحات با کلمات کلیدی جستجوشده، مفهوم کلمات و… هستند.

در واقع این الگوریتمها هستند که میزان اعتبار سایتهای برتر را در صفحه نتایج سرچ، به کاربر نشان میدهند و به این دلیل طراحی شدهاند که سایتها در ارائه محتوای باکیفیت و مفید برای کاربر به بهترین شکل ممکن عمل کنند.

نحوه کار موتور جستجوی گوگل

موتور جستجوی گوگل از سه بخش اصلی تشکیل شده است:

1. خزنده (Crawler):

- رباتهایی هستند که صفحات وب را در اینترنت جستجو و بررسی میکنند.

- با دنبال کردن لینکها از یک صفحه به صفحه دیگر، اطلاعات مربوط به صفحات را جمعآوری میکنند.

- اطلاعات جمعآوری شده را در فهرست گوگل (Google Index) ذخیره میکنند.

2. فهرست گوگل (Google Index):

- پایگاه داده عظیمی از اطلاعات مربوط به صفحات وب است.

- شامل اطلاعاتی مانند عنوان صفحه، متن صفحه، تصاویر و لینکها است.

3. الگوریتم رتبهبندی (Ranking Algorithm):

- از اطلاعات موجود در فهرست گوگل برای رتبهبندی صفحات وب در نتایج جستجو استفاده میکند.

- فاکتورهای مختلفی را برای رتبهبندی صفحات در نظر میگیرد، مانند:

- محتوای صفحه

- کیفیت لینکها به صفحه

- تجربه کاربری

گوگل در تلاش است تا شما را درک کند، اما همیشه موفق نیست! ( مجید سالاری )

الگوریتم گوگل مانند یک مترجم عمل میکند که سعی دارد منظور شما از عبارات جستجو را بفهمد و صفحات مرتبط را به شما نشان دهد.

در بیشتر موارد، این کار به خوبی انجام میشود و شما به سرعت به اطلاعات مورد نیاز خود میرسید.

اما گاهی اوقات، گوگل اشتباه میکند و نتایج ایدهآلی را به شما ارائه نمیدهد.

دلایل مختلفی برای این اتفاق وجود دارد:

- عبارات جستجو میتوانند مبهم باشند: ممکن است منظور شما از یک عبارت، با برداشت گوگل از آن متفاوت باشد.

- الگوریتم گوگل کامل نیست: این الگوریتم با هوش مصنوعی کار میکند و هنوز در حال یادگیری است.

- صفحات وب به طور مداوم در حال تغییر هستند: ممکن است گوگل از جدیدترین تغییرات یک صفحه وب اطلاع نداشته باشد.

مراحل کار موتور جستجوی گوگل:

- خزنده (Crawler) صفحات وب را در اینترنت جستجو میکند.

- اطلاعات مربوط به صفحات را جمعآوری و در فهرست گوگل (Google Index) ذخیره میکند.

- هنگامی که کاربر عبارتی را جستجو میکند، الگوریتم رتبهبندی (Ranking Algorithm) صفحات مرتبط با آن عبارت را پیدا میکند.

- صفحات مرتبط را بر اساس رتبهبندی، به کاربر نمایش میدهد.

نکاتی در مورد نحوه کار موتور جستجوی گوگل:

- الگوریتم های موتور جستجوی گوگل دائماً در حال بهروزرسانی است و الگوریتم رتبهبندی سئو آن به طور مداوم تغییر میکند.

- برای بهبود رتبهبندی وب سایت خود در نتایج جستجوی گوگل، باید به سئو (SEO) توجه کنید.

- سئو به معنای بهینهسازی وب سایت برای موتورهای جستجو است.

معرفی الگوریتم های گوگل

در این قسمت به معرفی الگوریتمهای گوگل پرداختهایم. این الگوریتمها عبارتند از:

الگوریتم فلوریدا (Florida)

فلوریدا یک الگوریتم تحلیل لینک است و به دنبال این است که لینک های اسپم یعنی لینکهایی که از راههای مخالف با قوانین گوگل و نادرست به وجود آمدهاند را شناسایی کند و سایتهایی را که از طریق بکلینکهای غیرمجاز میخواهند رتبه بگیرند، جریمه میکند.

وظایف الگوریتم فلوریدا

وظایف اصلی الگوریتم فلوریدار عبارتند از:

1. مبارزه با تقلب و اسپم:

-

- شناسایی و جریمه وب سایتهایی که از روشهای غیرقانونی برای افزایش رتبه خود در نتایج جستجو استفاده میکنند.

- این روشها شامل مواردی مانند خرید بک لینک، استفاده از کلمات کلیدی پنهان و تولید محتوای بیکیفیت میشود.

2. بهبود کیفیت نتایج جستجو:

-

- بالا بردن رتبه وب سایتهایی که محتوای باکیفیت و مفید ارائه میکنند.

- این کار به کاربران کمک میکند تا به اطلاعات مورد نیاز خود به سرعت و به آسانی دسترسی پیدا کنند.

3. ایجاد تنوع در نتایج جستجو:

-

- جلوگیری از انحصار نتایج جستجو توسط تعداد محدودی از وب سایتها.

- این کار به کاربران کمک میکند تا با طیف وسیعتری از اطلاعات و دیدگاهها آشنا شوند.

تاثیر الگوریتم فلوریدا:

-

- الگوریتم فلوریدا تاثیر قابل توجهی بر سئو (SEO) و رتبهبندی وب سایتها در نتایج جستجو داشته است.

- وب سایتهایی که از این الگوریتم پیروی میکنند، شانس بیشتری برای کسب رتبه بالا در نتایج جستجو دارند.

چگونه از جریمه الگوریتم فلوریدا در امان باشیم

برای در امان ماندن از جریمه الگوریتم فلوریدا، باید به نکات زیر توجه کنید:

1. محتوای باکیفیت و مفید تولید کنید:

- محتوای شما باید برای کاربران مفید و جذاب باشد.

- از کلمات کلیدی به طور طبیعی و اصولی در محتوای خود استفاده کنید.

- از کپی کردن محتوای دیگران خودداری کنید.

2. به سئوی تکنیکال وب سایت خود توجه کنید:

- سرعت بارگذاری وب سایت خود را افزایش دهید.

- از ساختار مناسب برای وب سایت خود استفاده کنید.

- از تصاویر و ویدئوها به طور صحیح استفاده کنید.

3. لینکهای طبیعی به وب سایت خود ایجاد کنید:

- از روشهای غیرقانونی مانند خرید بک لینک خودداری کنید.

- از سایر وب سایتها بخواهید که به وب سایت شما لینک بدهند.

- در شبکههای اجتماعی فعال باشید و محتوای خود را به اشتراک بگذارید.

4. از روشهای غیرقانونی برای افزایش رتبه خودداری کنید:

- از کلمات کلیدی پنهان استفاده نکنید.

- محتوای تقلبی و اسپم تولید نکنید.

- از روشهای فریبنده برای افزایش رتبه خود استفاده نکنید.

تاثیر الگوریتم فلوریدا:

- الگوریتم فلوریدا تاثیر قابل توجهی بر سئو (SEO) و رتبهبندی وب سایتها در نتایج جستجو داشته است.

- وب سایتهایی که از این الگوریتم پیروی میکنند، شانس بیشتری برای کسب رتبه بالا در نتایج جستجو دارند.

اگر میخواهید درباره بک لینکها اطلاعات بیشتری را به دست آورید، مقاله انواع بک لینک را مطالعه کنید.

جگر (Jagger)

الگوریتم جگر گوگل که به Google Jagger Update نیز شناخته میشود، یکی از الگوریتمهای مهم گوگل بود که در سال 2005 معرفی شد.

هدف اصلی این الگوریتم، مبارزه با لینک سازی غیرطبیعی و محتوای تکراری بود.

تاثیرات الگوریتم جگر گوگل:

- کاهش رتبه وب سایتهایی که از روشهای غیرطبیعی برای لینک سازی استفاده میکردند: خرید بک لینک، تبادل لینک و استفاده از لینکهای پولی از جمله روشهایی بودند که توسط الگوریتم جگر جریمه میشدند.

- کاهش رتبه وب سایتهایی که محتوای تکراری ارائه میکردند: کپی کردن محتوا از سایر وب سایتها یا استفاده از محتوای اسپم میتوانست منجر به جریمه شدن وب سایت توسط الگوریتم جگر شود.

تاثیرات الگوریتم جگر تا به امروز نیز ادامه دارد و این الگوریتم به عنوان یکی از پایههای اصلی سئوی مدرن شناخته میشود.

نکاتی برای بهینه سازی وب سایت برای الگوریتم جگر:

- ایجاد لینکهای طبیعی: از سایر وب سایتها بخواهید که به وب سایت شما لینک بدهند.

- تولید محتوای باکیفیت و منحصر به فرد: محتوای شما باید برای کاربران جذاب باشد و به سوالات آنها پاسخ دهد.

- اجتناب از روشهای غیرقانونی: از روشهای غیرقانونی مانند خرید بک لینک و استفاده از محتوای تکراری خودداری کنید.

با رعایت این نکات، میتوانید شانس خود را برای کسب رتبه بالا در نتایج جستجو و در امان ماندن از جریمه الگوریتم جگر افزایش دهید.

توجه:

- الگوریتم جگر در سال 2012 با الگوریتم پنگوئن ادغام شد.

- الگوریتم پنگوئن به طور مداوم در حال بهروزرسانی است و گوگل به طور مرتب با روشهای جدید لینک سازی غیرطبیعی و محتوای تکراری مبارزه میکند.

- برای کسب اطلاعات بیشتر در مورد الگوریتم جگر و سئو، میتوانید به منابع معتبر مانند وب سایت گوگل و Moz مراجعه کنید.

الگوریتم وینس برای سئو (Vince)

الگوریتم وینس که به Google Vince Update نیز شناخته میشود، یکی از الگوریتمهای مهم گوگل است که در سال 2009 معرفی شد.

هدف اصلی این الگوریتم، افزایش رتبه وب سایتهای برندهای شناخته شده در نتایج جستجو بود.

تاثیرات الگوریتم وینس:

- افزایش رتبه وب سایتهای برندهای شناخته شده: وب سایتهایی که برند شناخته شدهای داشتند، حتی اگر محتوای آنها به اندازه وب سایتهای دیگر باکیفیت نبود، رتبه بهتری در نتایج جستجو کسب میکردند.

- کاهش رتبه وب سایتهای کوچک و ناشناخته: وب سایتهایی که برند شناخته شدهای نداشتند، حتی اگر محتوای آنها باکیفیت بود، رتبه پایینتری در نتایج جستجو کسب میکردند.

تاثیرات الگوریتم وینس تا به امروز نیز ادامه دارد و این الگوریتم به عنوان یکی از عوامل موثر در رتبهبندی وب سایتها در نتایج جستجو شناخته میشود.

نکاتی برای بهینه سازی وب سایت برای الگوریتم وینس:

- ایجاد برند قوی: برای برند خود نام و نشانی قوی ایجاد کنید.

- تولید محتوای باکیفیت: محتوای شما باید برای کاربران جذاب باشد و به سوالات آنها پاسخ دهد.

- ایجاد لینکهای طبیعی: از سایر وب سایتها بخواهید که به وب سایت شما لینک بدهند.

- فعالیت در شبکههای اجتماعی: در شبکههای اجتماعی فعال باشید و محتوای خود را به اشتراک بگذارید.

با رعایت این نکات، میتوانید شانس خود را برای کسب رتبه بالا در نتایج جستجو و در امان ماندن از جریمه الگوریتم وینس افزایش دهید.

توجه:

- الگوریتم وینس فقط یکی از عوامل موثر در رتبهبندی وب سایتها در نتایج جستجو است.

- الگوریتمهای گوگل دائماً در حال بهروزرسانی هستند و فاکتورهای جدیدی به رتبهبندی وب سایتها اضافه میشوند.

- برای کسب اطلاعات بیشتر در مورد الگوریتم وینس و سئو، میتوانید به منابع معتبر مانند وب سایت گوگل و Moz مراجعه کنید.

الگوریتم اسپم برین گوگل برای seo (Spam Brain)

- تاریخ معرفی: 2018

- هدف: مبارزه با محتوای اسپم و تقلب

- نوع الگوریتم: هوش مصنوعی

- تاثیر بر: رتبه وب سایت در نتایج جستجو

الگوریتم اسپم برین (SpamBrain) یکی از الگوریتمهای مهم گوگل است که در سال 2018 معرفی شد.

هدف اصلی این الگوریتم، مبارزه با محتوای اسپم و تقلب در نتایج جستجو و ارتقای کیفیت محتوای نمایش داده شده به کاربران است.

اسپم برین از هوش مصنوعی برای شناسایی و جریمه وب سایتهایی که از روشهای اسپم و فریبنده برای افزایش رتبه خود در نتایج جستجو استفاده میکنند، بهره میبرد.

تاثیرات الگوریتم اسپم برین:

- کاهش رتبه وب سایتهایی که محتوای اسپم و تقلبی ارائه میکنند: محتوای اسپم شامل محتوای بیکیفیت، تکراری، کپی شده و یا محتوایی که به طور غیرطبیعی برای کلمات کلیدی بهینه شده باشد، میشود.

- افزایش رتبه وب سایتهایی که محتوای باکیفیت و مفید ارائه میکنند: محتوای باکیفیت محتوایی است که برای کاربران جذاب باشد، به سوالات آنها پاسخ دهد و به طور طبیعی برای کلمات کلیدی بهینه شده باشد.

تاثیرات الگوریتم اسپم برین تا به امروز نیز ادامه دارد و این الگوریتم به عنوان یکی از پایههای اصلی سئوی مدرن شناخته میشود.

نکاتی برای بهینه سازی وب سایت برای الگوریتم اسپم برین:

- تولید محتوای باکیفیت و منحصر به فرد: محتوای شما باید برای کاربران جذاب باشد و به سوالات آنها پاسخ دهد.

- استفاده از کلمات کلیدی به طور طبیعی: از کلمات کلیدی به طور طبیعی و در متن محتوا استفاده کنید.

- اجتناب از روشهای غیرقانونی: از روشهای غیرقانونی مانند خرید بک لینک، استفاده از کلمات کلیدی پنهان و تولید محتوای اسپم خودداری کنید.

- ایجاد لینکهای طبیعی: از سایر وب سایتها بخواهید که به وب سایت شما لینک بدهند.

- به روز رسانی محتوا: محتوای وب سایت خود را به طور مرتب به روز رسانی کنید.

با رعایت این نکات، میتوانید شانس خود را برای کسب رتبه بالا در نتایج جستجو و در امان ماندن از جریمه الگوریتم اسپم برین افزایش دهید.

توجه:

- الگوریتم اسپم برین به طور مداوم در حال بهروزرسانی است و گوگل به طور مرتب با روشهای جدید اسپم و تقلب مبارزه میکند.

الگوریتم کافئین گوگل برای سئو (Caffeine)

با کمک الگوریتم کافئین گوگل این قابلیت را یافته که صفحات را با سرعت بیشتری کرال و ایندکس کند و در نتیجه نتایج بهتری را سریعتر به کاربر نمایش دهد.

الگوریتم رقص گوگل (Google Dance)

الگوریتم رقص گوگل (Google Dance) که به Google Fluctuation نیز شناخته میشود، به پدیدهای در نتایج جستجوی گوگل اشاره دارد که در آن رتبه و جایگاه صفحات وب در کلمات کلیدی مختلف، به طور ناگهانی و موقتی تغییر میکند.

- تاریخ معرفی: نامشخص (احتمالاً اواخر دهه 1990)

- هدف:

- جلوگیری از دستکاری نتایج جستجو

- ارزیابی واکنش کاربران به تغییرات رتبهبندی

- به روز رسانی الگوریتمهای رتبهبندی

- نوع الگوریتم:

- الگوریتم دقیق آن مشخص نیست

- احتمالاً از مجموعهای از الگوریتمها استفاده میکند

- تاثیر بر:

- رتبه وب سایت در نتایج جستجو

- ترافیک وب سایت

- نکات مهم:

- رقص گوگل میتواند به طور روزانه، هفتگی یا ماهانه اتفاق بیفتد.

- رقص گوگل میتواند بر صفحات وب به صورت جداگانه یا گروهی تاثیر بگذارد.

- رقص گوگل میتواند موقتی یا دائمی باشد.

تاثیرات الگوریتم رقص گوگل:

- تغییر ناگهانی در رتبه وب سایت در نتایج جستجو:

- ممکن است رتبه وب سایت شما به طور ناگهانی بالا یا پایین برود.

- این تغییر رتبه میتواند موقتی یا دائمی باشد.

- تغییر در ترافیک وب سایت:

- ممکن است ترافیک وب سایت شما به طور ناگهانی افزایش یا کاهش یابد.

- این تغییر ترافیک میتواند به دلیل تغییر رتبه وب سایت شما باشد.

نکاتی برای بهینه سازی وب سایت برای الگوریتم رقص گوگل:

- تولید محتوای باکیفیت و منحصر به فرد: محتوای شما باید برای کاربران جذاب باشد و به سوالات آنها پاسخ دهد.

- استفاده از کلمات کلیدی به طور طبیعی: از کلمات کلیدی به طور طبیعی و در متن محتوا استفاده کنید.

- ایجاد لینکهای طبیعی: از سایر وب سایتها بخواهید که به وب سایت شما لینک بدهند.

- به روز رسانی محتوا: محتوای وب سایت خود را به طور مرتب به روز رسانی کنید.

- صبر و حوصله: رقص گوگل پدیدهای طبیعی است و جای نگرانی ندارد.

- تمرکز بر سئوی بلندمدت: به جای تمرکز بر رتبههای کوتاهمدت، بر سئوی بلندمدت تمرکز کنید.

با رعایت این نکات، میتوانید شانس خود را برای کسب رتبه بالا در نتایج جستجو و در امان ماندن از تاثیرات منفی رقص گوگل افزایش دهید.

الگوریتم تازگی محتوا (Freshness Algorithm)

الگوریتم تازگی (Freshness Algorithm) یکی از الگوریتمهای مهم گوگل است که به منظور ارزیابی و رتبهبندی محتوای جدید و بهروز در نتایج جستجو طراحی شده است.

هدف اصلی این الگوریتم، ارائه محتوای جدید و مرتبط به کاربران و تشویق وبمسترها به تولید محتوای تازه و باکیفیت است.

مشخصات کلی الگوریتم تازگی:

-

تاریخ معرفی: نامشخص (احتمالاً اواخر دهه 2000)

-

هدف:

- ارائه محتوای جدید و مرتبط به کاربران

- تشویق وبمسترها به تولید محتوای تازه و باکیفیت

- مبارزه با محتوای قدیمی و منسوخ

-

نوع الگوریتم:

- الگوریتم دقیق آن مشخص نیست

- احتمالاً از مجموعهای از سیگنالها برای ارزیابی تازگی محتوا استفاده میکند

-

تاثیر بر:

- رتبه وب سایت در نتایج جستجو

- ترافیک وب سایت

-

نکات مهم:

- الگوریتم تازگی به طور مداوم در حال بهروزرسانی است.

- تازگی محتوا فقط یکی از فاکتورهای رتبهبندی گوگل است.

- کیفیت محتوا، اعتبار وب سایت و سایر فاکتورها نیز در رتبهبندی وب سایت نقش دارند.

تاثیرات الگوریتم تازگی:

- افزایش رتبه وب سایتهایی که محتوای جدید و بهروز تولید میکنند:

- وب سایتهایی که به طور مرتب محتوای جدید و باکیفیت منتشر میکنند، در نتایج جستجو رتبه بالاتری کسب میکنند.

- کاهش رتبه وب سایتهایی که محتوای قدیمی و منسوخ دارند:

- وب سایتهایی که محتوای آنها قدیمی و منسوخ است، در نتایج جستجو رتبه پایینتری کسب میکنند.

نکاتی برای بهینه سازی وب سایت برای الگوریتم تازگی:

- تولید محتوای جدید و بهروز:

- به طور مرتب محتوای جدید و باکیفیت در وب سایت خود منتشر کنید.

- به روز رسانی محتوای قدیمی:

- محتوای قدیمی وب سایت خود را به روز رسانی و اصلاح کنید.

- استفاده از تاریخ انتشار:

- از تاریخ انتشار برای محتوای خود استفاده کنید.

- استفاده از RSS Feed:

- از RSS Feed برای انتشار محتوای خود در سایر وب سایتها و شبکههای اجتماعی استفاده کنید.

- اشتراک گذاری محتوا در شبکههای اجتماعی:

- محتوای خود را در شبکههای اجتماعی به اشتراک بگذارید.

الگوریتم صفحه آرایی (Page Layout Algorithm)

الگوریتم صفحه آرایی (Layout Algorithm) یکی از الگوریتمهای گوگل است که به منظور ارزیابی و رتبهبندی صفحات وب بر اساس نحوه چیدمان و ساختار محتوای آنها طراحی شده است.

هدف اصلی این الگوریتم، ارائه تجربه کاربری بهتر به کاربران و تشویق وبمسترها به طراحی صفحات وب کاربرپسند و جذاب است.

مشخصات کلی الگوریتم صفحه آرایی:

-

تاریخ معرفی: 2012

-

هدف:

- ارائه تجربه کاربری بهتر به کاربران

- تشویق وبمسترها به طراحی صفحات وب کاربرپسند و جذاب

- مبارزه با صفحات وب با طراحی نامناسب و غیرقابل استفاده

-

نوع الگوریتم:

- الگوریتم دقیق آن مشخص نیست

- احتمالاً از مجموعهای از سیگنالها برای ارزیابی چیدمان و ساختار محتوا استفاده میکند

-

تاثیر بر:

- رتبه وب سایت در نتایج جستجو

- ترافیک وب سایت

-

نکات مهم:

- الگوریتم صفحه آرایی به طور مداوم در حال بهروزرسانی است.

- چیدمان و ساختار محتوا فقط یکی از فاکتورهای رتبهبندی گوگل است.

- کیفیت محتوا، اعتبار وب سایت و سایر فاکتورها نیز در رتبهبندی وب سایت نقش دارند.

فاکتورهای مورد نظر الگوریتم صفحه آرایی:

- خوانایی:

- محتوای صفحه باید به راحتی قابل خواندن و فهم باشد.

- قابل استفاده بودن:

- کاربران باید به راحتی بتوانند در صفحه وب پیمایش کنند و به اطلاعات مورد نظر خود دسترسی پیدا کنند.

- جذابیت:

- صفحه وب باید از نظر بصری جذاب باشد و کاربران را به خود جذب کند.

- سرعت بارگذاری:

- صفحه وب باید به سرعت بارگذاری شود.

- سازگاری با موبایل:

- صفحه وب باید با دستگاههای موبایل سازگار باشد.

نکاتی برای بهینه سازی وب سایت برای الگوریتم صفحه آرایی:

- استفاده از فونت مناسب:

- از فونتی استفاده کنید که به راحتی قابل خواندن باشد.

- استفاده از عناوین و زیرعنوانها:

- از عناوین و زیرعنوانها برای سازماندهی محتوای صفحه استفاده کنید.

- استفاده از تصاویر و ویدیوها:

- از تصاویر و ویدیوها برای جذابتر کردن صفحه استفاده کنید.

- استفاده از فضای سفید:

- از فضای سفید برای جلوگیری از شلوغی صفحه استفاده کنید.

- استفاده از دکمهها و لینکهای واضح:

- از دکمهها و لینکهای واضح برای پیمایش در صفحه استفاده کنید.

- بهینه سازی سرعت بارگذاری:

- سرعت بارگذاری صفحه وب خود را بهینه کنید.

- بهینه سازی برای موبایل:

- صفحه وب خود را برای دستگاههای موبایل بهینه کنید.

با رعایت این نکات، میتوانید شانس خود را برای کسب رتبه بالا در نتایج جستجو و در امان ماندن از تاثیرات منفی الگوریتم صفحه آرایی افزایش دهید.

توجه:

- الگوریتم صفحه آرایی فقط یکی از الگوریتمهای گوگل است و برای کسب رتبه بالا در نتایج جستجو، باید به سایر فاکتورهای رتبهبندی گوگل نیز توجه کنید.

سندباکس گوگل (Sandbox)

سند باکس وظیفه دارد که به سایتهای تازه تأسیس فرصت دهد تا سئوی خود را بهبود بخشند و صفحات، لینکها، سرعت بارگذاری، مقالات، نمایش صفحات روی موبایل را بررسی میکند و بعد از سه تا شش ماه تعیین میکند که عملکرد سایت در بهینه سازی موفق بوده است یا خیر.

-

هدف:

- جلوگیری از رتبهبندی سریع وب سایتهای جدید با استفاده از تکنیکهای سئو کلاه سیاه

- ایجاد فرصت برای وب سایتهای جدید برای اثبات کیفیت خود

-

نوع الگوریتم:

- الگوریتم دقیق آن مشخص نیست

- احتمالاً از مجموعهای از سیگنالها برای شناسایی وب سایتهای جدید استفاده میکند

-

تاثیر بر:

- رتبه وب سایت در نتایج جستجو

- ترافیک وب سایت

-

نکات مهم:

- سندباکس گوگل به طور مداوم در حال بهروزرسانی است.

- مدت زمان ماندگاری وب سایت در سندباکس گوگل مشخص نیست.

- وب سایتهایی که از تکنیکهای سئو کلاه سیاه استفاده میکنند، ممکن است برای مدت طولانیتری در سندباکس باقی بمانند.

تاثیرات سندباکس گوگل:

- کاهش رتبه وب سایتهای جدید در نتایج جستجو:

- وب سایتهای جدید ممکن است برای مدتی پس از انتشار، در رتبههای پایین نتایج جستجو قرار بگیرند.

- کاهش ترافیک وب سایت:

- وب سایتهایی که در سندباکس گوگل قرار دارند، ممکن است ترافیک کمتری از طریق جستجوی گوگل دریافت کنند.

نکاتی برای خروج از سندباکس گوگل:

- تولید محتوای باکیفیت و منحصر به فرد: محتوای شما باید برای کاربران جذاب باشد و به سوالات آنها پاسخ دهد.

- استفاده از کلمات کلیدی به طور طبیعی: از کلمات کلیدی به طور طبیعی و در متن محتوا استفاده کنید.

- ایجاد لینکهای طبیعی: از سایر وب سایتها بخواهید که به وب سایت شما لینک بدهند.

- به روز رسانی محتوا: محتوای وب سایت خود را به طور مرتب به روز رسانی کنید.

- صبر و حوصله: خروج از سندباکس گوگل ممکن است زمان ببرد.

با رعایت این نکات، میتوانید شانس خود را برای خروج سریعتر از سندباکس گوگل و کسب رتبه بالا در نتایج جستجو افزایش دهید.

EMD (دامنه تطبیق دقیق)

Exact Match Domains یا دامنههای تطبیق دقیق باعث نمایش صفحات به دلیل استفاده دقیق از عبارات کلیدی مرتبط با موضوع میشود.

پیشنهاد گوگل (Google Suggest)

گوگل برای این که به کاربران در جستجوی بهتر موضوع کمک کنند، پیشنهاداتی را توسط گوگل ساجست به آنها میدهد. این پیشنهادات با سابقه جستجوی کاربر، محبوبیت کلمات کلیدی و عبارات مشابه تعیین میشوند.

جستجوی شخصی گوگل (Google Personalized Search)

این الگوریتم با بررسی سوابق فرد در جستجو و مشاهده صفحات مورد علاقه آنها، نتایجی که بیشترین نزدیکی را به سلیقه آنها دارد در صفحه نتایج سرچ به ایشان نمایش میدهد.

گوگل بوستون (Google Boston)

برای بهبود تجربه جستجوی کاربران، گوگل بر آن شد تا الگوریتمی برای درک مفهوم سؤالات کاربران و یافتن ارتباط آنها با محتواها پیادهسازی کند. سؤالات متداول طولانی و کلمات کلیدی لانگ ترم با استفاده از آن درک شده و بر اساس مفهوم آنها محتواهای مناسب به کاربر نمایش داده میشود.

جستجوی جهانی گوگل (Google Universal Search)

در به روزرسانی گوگل توسط این الگوریتم، در صفحه نتایج دستهبندیهای مختلف مانند کتابها، فیلمها، عکسها و… که مرتبط با موضوع بودند از هم تفکیک شدند.

فانتوم گوگل (Google Phantom)

یک ترکیب قوی از الگوریتمهای پاندا و پنگوئن که بر کیفیت محتوا و لینکهای ورودی و همچنین تجربه کاربری خوب تاکید دارد با نام فانتوم شناخته میشود. هر چقدر محتوای ارزشمند در یک صفحه کاربرپسندتری ارائه شود، با استفاده از این الگوریتم رتبه بالاتری را در نتایج گوگل به دست خواهد آورد.

روز پرداخت (PayDay)

برخی از سایتهایی که از روشهای اسپم برای دور زدن گوگل و افزایش رتبه خود در SERP استفاده میکنند، توسط این الگوریتم شناسایی و جریمه میشوند. قبل از پیاده سازی پی دی برخی از سایتها از کلمات کلیدی نامرتبط و پرکاربرد برای افزایش ترافیک سایت خود استفاده میکردند. این الگوریتم این سایتها را شناسایی نموده و سایتهایی با محتوای باکیفیت و مرتبط با آن کلمات کلیدی را نسبت به آنها در اولویت قرار داد.

Intrusive Interstitials Penalty

با کمک این الگوریتم صفحاتی که تجربه کاربری بهتری دارند در رتبههای بالاتر و آنهایی که با صفحات پاپ آپ یا پنهانسازی بخشی از محتوا باعث آزار کاربر میشوند شناسایی میشوند و دچار افت رتبه میشوند.

اعتبار صفحه (Page Authority)

طبق پیج آتوریتی هنگامی که یک صفحه از تبلیغات بیش از حد استفاده میکند، باعث اذیت کاربر میشود و این موضوع از نظر گوگل یک نکته منفی است و باعث کاهش رتبه سایت میشود.

ماه عسل (Honeymoon)

صفحات جدید توسط این الگوریتم در روزهای اول در صفحه اول صفحه نتایج جستجوی گوگل قرار میگیرند و بعد از بررسی عملکرد سایت، صفحات آن مجددا رتبهبندی میشوند.

هیل تاپ (Hilltop)

الگوریتم هیلتاپ در کنار پیج رنک صفحاتی را که دارای اعتبار و تخصص کافی هستند شناسایی میکند و به آنها جایگاه میدهد.

Mobilegeddon

تمرکز این الگوریتم روی افزایش رتبه سئو به سایتهایی است که طراحی ریسپانسیو و موبایل فرندلی را ارائه میدهند.

الگوریتم دزد دریایی (Pirate)

کاربرد این الگوریتم در زمینه کپی رایت محتواهاست و در مواردی که محتوای دارای کپی رایت بدون اجازه صاحب امتیاز منتشر شود، مچ شما را میگیرد.

الگوریتم گور خر (Zebra)

این الگوریتم سایتهای فروشگاهی را که به کلاهبرداری از مردم در فروش اینترنتی میپردازند شناسایی میکند.

الگوریتم موش کور (Possum)

موش کور در جستجوی ارگانیک کاربرد دارد و در این مورد به سایتها و کاربران کمک میکند.

الگوریتم مام (MUM)

این الگوریتم توانایی خواندن متون و درک مفهوم را دارد و میتواند به سؤالات پیچیده کاربران پاسخ دهد. با روی کار آمدن مام، تمامی محتواهای متنی، تصویری، صوتی و ویدیویی توسط گوگل درک میشوند و در رتبهبندی تأثیر دارند.

الگوریتم محتوای مفید (Helpful Content)

گوگل با استفاده از این الگوریتم محتواهای مفیدتر را شناسایی میکند و آنها را در رتبههای برتر SERP قرار میدهد.

الگوریتم سؤالات متداول و داده ساختاریافته (FAQ & Structured Data)

از نظر گوگل هر چقدر یک محتوا در رعایت ساختار اصولی بهتر عمل کند و از سؤالات متداول استفاده کند، ارزش بیشتری دارد.

الگوریتم گراف دانش گوگل (Google Knowledge Graph)

گراف دانش به این منظور به وجود آمد که افراد با سرعت و سهولت بیشتری به مفاهیم مورد نظر خود دسترسی یابند. این کار با جمعآوری پانصدمیلیون مفهوم و 3.5 میلیون قانون درباره موجودات و مفاهیم دنیای واقعی و روابط بین آنها توسط این الگوریتم عملی شد. این پایگاه دانش روز به روز قویتر و پربارتر میشود و به گوگل در درک مفاهیم محتواهای سایتها کمک میکند.

الگوریتم پاندا (Panda)

این الگوریتم در سال 2011 ایجاد شد تا چک کند که شما در مورد یک موضوع دو محتوا یا محتوای کپی از سایتهای دیگر نداشته باشید. همچنین محتوای کم و غیر مفید مثلا یک محتوای 15 کلمهای یا محتوای بیکیفیت که نیاز کاربر را برآورده نکند ارزشی در سئو ندارد.

الگوریتم پنگوئن (Penguin)

این الگوریتم در سال 2011 طراحی شد که به لینکهای اسپم و لینکهای تبلیغاتی رسیدگی میکند؛ مثلاً زمانی که شما لینکی را خریداری میکنید، ممکن است شما را جریمه کند. البته هنوز نمیتواند متوجه خرید بک لینک در سایتهای فارسی زبان شود. پنگوئن علاوه بر لینکها، استفاده صحیح از کلمات کلیدی در لینکها توسط سایت را نیز بررسی میکند و در صورت مغایرت با قوانین گوگل آن را جریمه میکند.

الگوریتم مرغ مگس خوار (Hummingbird)

هامینگبرد به معنی پشت کلمات دقت میکند. در گذشته الگوریتمها فقط کلمه را میدیدند؛ اما امروزه میتوانند با استفاده از این الگوریتم مفهوم آن را بفهمند. به عنوان مثال با کمک این الگوریتم های سئو گوگل تمایز بین شیر (حیوان) و شیر (نوشیدنی) را درک میکند.

کبوتر، پیجن (pigeon)

پیجن در سال 2014 ایجاد شده و کار آن سرچ محلی است. در سرچ با کمک پیجن مواردی که محل زندگی روی آن تأثیر دارد لحاظ میشود؛ به عنوان مثال سرچ کلمه کلیدی “خرید خانه” با توجه به محل زندگی شما نتایج متفاوتی دارد. نتایج سرچ گوگل در مورد این کلمه کلیدی برای فردی که در تهران زندگی میکند با فردی که در لندن زندگی میکند متفاوت است. سرچ انگلیسی قطعا نتایج متفاوتی با سرچ فارسی دارد. گاهی حتی محل زندگی در یک شهر هم در نتایج سرچ تأثیرگذار است؛ مثلاً سرچ در خانی آباد برای خرید خانه با سرچ در جردن متفاوت است.

الگوریتم رنک برین (RankBrain)

رنک برین در سال 2015 وارد شده و یک ماشین لرنینگ است که رتبهها را بررسی میکند. این الگوریتم هوشمند رتبه شما را به صورت مداوم در نتایج گوگل رصد میکند و مثلاً یک بار شما را در رتبه 1 قرار میدهد و عکس العمل کاربران را با زمانی که شما در رتبه 3 هستید، مقایسه میکند و از این طریق مناسبترین جایگاه را برای شما تعیین میکند.

موبایل فرست ایندکس (Mobile-first indexing)

در حال حاضر تکنولوژی در حال حرکت به سمتی است که نسخه موبایل و تبلت برخی از سایتها برای گوگل از اهمیت بیشتری برخوردارند. با استفاده از این الگوریتم گوگل نسخه موبایل برخی از سایتها را بسته به موضوع و کاربری آن برای ایندکس در اولویت اهمیت قرار میدهد. بنابراین کارشناس سئو باید در حین آنالیز نسخه لپ تاپ، نسخه موبایل را هم چک کند.

الگوریتم فرد (Fred)

بعضی از سایتها از تکنیکهای کلاه سیاه برای افزایش درآمد خود استفاده میکند؛ مانند سایتهایی که آگهی زیادی دارند. این موضوع کاربر را اذیت میکند. این الگوریتم وظیفه دارد که این گونه سایتها را شناسایی کند و از رتبهگرفتن آنها در SERP جلوگیری کند.

الگوریتم مدیک آپدیت (Medic Update)

سایتهایی که با پول و زندگی شما سرو کار دارند (YMYL)، تحت تاثیر این الگوریتم هستند. این نوع سایتها از حساسیت خاصی برخوردارند و به همین دلیل باید در ارائه محتوای خود قوانینی را رعایت کنند. از مهمترین سایتهایی که توسط مدیک آپدیت رصد میشوند، سایتهای پزشکی هستند و به دلیل حساسیت بالای موضوع باید سابقه نویسندگان خود را به طور شفاف به گوگل نشان دهند. فرد نویسنده در این سایتها باید از تجربه، تخصص و اعتبار کافی برخوردار باشد.

الگوریتم برت (BERT)

ارتباط بین کلمات با استفاده از این الگوریتم بررسی میشود. مثلا در جمله خرید شیر میفهمد که به دلیل قابل خریداری بودن، منظور از شیر همان نوشیدنی است؛ یعنی بر اساس NLP(Natural Language Processing) زبان آدمیزاد را میفهمد. از طریق این الگوریتم گوگل میتواند مچ ما را در مواقعی که قصد دور زدن آن را داشته باشیم بگیرد؛ بنابراین باید همیشه به دنبال برطرفکردن نیاز مخاطب باشیم.

Passage Ranking

طبق این الگوریتم تک تک پاراگرافها در سئو اهمیت دارند. در حال حاضر همه پاراگرافها توسط گوگل کرال میشود و ممکن است حتی به دلیل یک پاراگراف به ما جایگاه خوبی بدهد.

Page Experience Update

تجربه خوب کاربر با توجه به یک سری فاکتورها توسط گوگل اندازه گیری میشود. کور وب وایتالز از مهمترین مواردی هستند که در این الگوریتم بررسی میشوند. موبایل فرندلی بودن و طراحی ریسپانسیو و امنیت سایت هم مهم هستند و هکشدن سایت باعث عدم اعتماد گوگل به شما میشود.

الگوریتم EEAT(Experience Expertise Authoritativeness Trustworthiness)

این الگوریتم نویسنده مقالات سایت را بررسی میکند. به این صورت که آیا فردی که مقاله را مینویسد تخصص دارد، تجربه دارد، اعتبار دارد و شناخته شده هست؟ آیا این فرد قابل اعتماد هست و میزان مراجعه به این فرد چقدر است؟ یکی از روشهای تشخیص آن باکس نویسنده و لینکهایی هستند که درباره نویسنده توضیح میدهند.

مقالات سایت یا باید توسط فرد متخصص نوشته شود یا این که اگر نویسنده تخصص لازم را ندارد، توسط یک فرد متخصص بازنگری و تایید شود. هم نویسنده و هم فرد بازنگر باید صفحهای مختص به خود به همراه رزومه داشته باشند. این افراد باید لینک لینکداین و سایر شبکههای اجتماعی را داشته باشند. با آمدن چت جی پی تی این مسئله اهمیت بیشتری مییابد و احتمال خطای چت جی پی تی باید توسط فرد متخصص بازنگری شود. این مورد برای سایتهای کوچک خیلی کاربردی است و میتواند برای آنها جایگاه خوبی را به دست آورد.

دلایل اهمیت الگوریتم ها و کاربرد آنها

برای این که بتوانیم سایت خود را تا جای ممکن برای موتورهای جستجو، مخصوصاً گوگل، بهینه کنیم، باید این الگوریتمها را بشناسیم و با عملکرد آنها آشنا شویم. در زیر به دلایل اهمیت الگوریتمهای گوگل اشاره شده است:

افزایش اعتبار و رتبه سایتهای کاربرپسند

از دلایل اصلی وجود الگوریتمهای گوگل این است که بهترین محتوا را به مخاطب نمایش دهد. در واقع گوگل از این راه برای افزایش اعتبار خود استفاده میکند و اگر شما با این الگوریتمها آشنا شوید، میتوانید خود را به معیارهای گوگل نزدیک و نزدیکتر کنید تا مورد پسند آن باشید. در این صورت میتوانید موفقیت بیشتری را در بین رقبای اینترنتی خود داشته باشید.

کاهش رتبه سایتهای بیکیفیت

برخی از سایتها سعی میکنند که از روشهای خلاف و غیرقانونی مانند استفاده زیاد از کلمات کلیدی، محتوای کپی و… برای افزایش رتبه خود در SERP استفاده کنند. الگوریتمهای گوگل به این منظور طراحی شدهاند که این سایتها را شناسایی کنند و مانع رشد آنها در نتایج جستجو شوند تا کاربران به بهترین محتواهای موجود دسترسی داشته باشند.

شناخت بهتر نسبت به چهارچوب فرآیند سئوی سایت

تا زمانی که شما با این چهارچوب و قوانین آشنا نشوید، نمیتوانید روی سئوی سایت خود در همه جوانب کار کنید و ممکن است در کار شما کاستیهایی وجود داشته باشد که از آن اطلاع نداشته باشید.

کاهش زمان رشد و توسعه سایت و برند شما

از طریق شناخت این الگوریتمها شما میتوانید با سرعت بیشتری روی افزایش رتبه سئوی خود کار کنید و در نتیجه زودتر به نتیجه دلخواه خود برسید.

پیشگیری از جریمه شدن سایت

کسب رتبه خوب برای سایت نیاز به زحمت و زمان دارد و ممکن است زحمات شما با یک اشتباه هدر رود و در نتیجه شما افت زیادی را در رتبه سئوی خود تجربه کنید؛ اما با افزایش آگاهی درباره نوع و عملکرد الگوریتمهای گوگل میتوانید از این اتفاق پیشگیری کنید.

تأثیر الگوریتم های گوگل بر رتبه بندی SERP

اولین هدف گوگل از طراحی الگوریتمهای خود و به روزرسانی مداوم آنها بهبود SERP برای جلب هرچه بیشتر رضایت کاربران است. گوگل تمام تلاش خود را در یافتن صفحات و سایتهای اسپم و حذف آنها از صفحه اول نتایج میکند و از طرفی قصد دارد به سایتهایی که محتواهای باکیفیت و تجربه کاربری خوبی را ارائه میدهند فرصت دیدهشدن و کسب رتبههای برتر را بدهد. با استفاده از این الگوریتمها مدیران سایت روز به روز در تولید محتوای با کیفیت و مفید مهارت بیشتری یافتند و با روشهای بهبود تجربه کاربری سایت خود بیشتر آشنا شدند.

تاریخچه الگوریتم های گوگل

اگر بخواهیم نگاهی کلی به تاریخچه و سال به وجود آمدن الگوریتمها بعد از سال 2010 بپردازیم، به صورت زیر خواهد بود:

- 2011: پاندا

- 2012: یونس، گراف دانش و پنگوئن

- 2013: مرغ مگس خوار

- 2014: کبوتر

- 2015: موبایل و رنک برین

- 2018: موبایل و مدیک

- 2019: برت

- 2021: پیج اکسپرینس

- 2022: محتوای مفید

- 2023: سؤالات متداول و داده ساختاریافته

مهم ترین الگوریتم ها در حال حاضر کدامند؟

در حال حاضر الگوریتمهای زیر از لحاظ گوگل از اهمیت بیشتری برخوردارند:

- پاندا

- پنگوئن

- مرغ مگس خوار

- کبوتر

- رنک برین

- فرست ایندکس

- مدیک آپدیت

- فرد

- برت

- Medic

- EEAT

- Passage Ranking

- Page Experience Update

اهمیتدادن به این الگوریتمها در بهبود رتبه SEO شما تأثیر چشمگیری دارد. برای این که بتوانید با این الگوریتمها و نحوه به کارگیری آنها بیشتر آشنا شوید، میتوانید از خدمات آموزش سئوی DMService کمک بگیرید.

جمعبندی

در این مقاله به معرفی الگوریتم های گوگل در سئو و تاریخچه پرداختیم. مهمترین این الگوریتمها شامل پاندا، پنگوئن، مرغ مگس خوار، رنک برین، مدیک آپدیت، فرد، برت، کبوتر، فرست ایندکس، EEAT، پسج رنکینگ و تجربه صفحه هستند. در داخل متن به شرح الگوریتمها پرداخته شد و دلایل اهمیت آنها نیز بیان شد.

امیدواریم مطالب ما مورد توجه شما عزیزان قرار گرفته باشد. اگر نظری درباره مقاله دارید، لطفاً در قسمت نظرات با ما به اشتراک بگذارید.